Hình ảnh ngôi sao điện ảnh người Mỹ Tom Hanks.

Philip Tully, một nhà khoa học dữ liệu tại công ty bảo mật FireEye, đã tạo ra một cú lừa có tên Hankses để kiểm tra xem phần mềm mã nguồn mở từ các phòng thí nghiệm trí tuệ nhân tạo có thể tiếp sức cho các chiến dịch thông tin sai lệch dễ dàng như thế nào. Và ông đã đưa ra kết luận: "Những người dù không có nhiều kinh nghiệm vẫn có thể sử dụng các mô hình học máy này và tạo ra những thứ có sức ảnh hưởng cực kỳ mạnh mẽ".

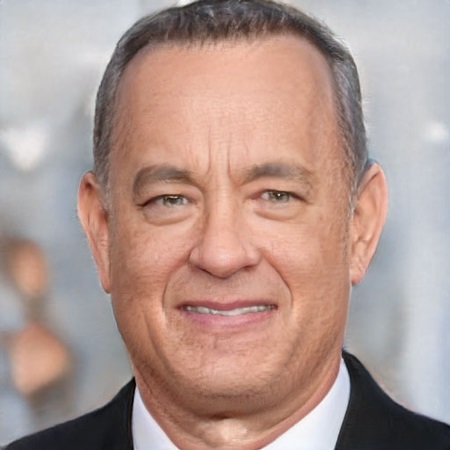

Nếu quan sát ở độ phân giải đầy đủ, bức ảnh giả của Hanks do FireEye tạo ra vẫn có những khuyết điểm như nếp nhăn ở cổ và kết cấu da không được tự nhiên. Nhưng họ đã tái tạo chính xác các chi tiết quen thuộc có trên gương mặt của nam tài tử điện ảnh này như là phần lông mày đặc trưng, đôi mắt màu xám xanh, cùng ánh mắt có phần ướt át. Tuy nhiên, đối với một bức ảnh thu nhỏ trên mạng xã hội, nhiều người sẽ dễ dàng lầm tưởng hình ảnh do AI tạo ra này là thật.

Để tạo ra chúng, Tully chỉ cần thu thập vài trăm hình ảnh trên mạng của Hanks và bỏ ra chưa đến 100 USD để điều chỉnh phần mềm sử dụng mã nguồn mở tạo khuôn mặt theo chủ đề đã chọn. Với phần mềm đã được tinh chỉnh, Tully có thể dễ dàng tạo ra một Hanks giả mạo. Ông ta cũng sử dụng thêm phần mềm AI mã nguồn mở khác để cố gắng bắt chước giọng nói của nam diễn viên từ 3 clip trên YouTube, dẫu vậy thì kết quả này có phần kém ấn tượng hơn.

Ảnh deepfake Hanks được tạo ra bởi các nhà nghiên cứu tại FireEye.

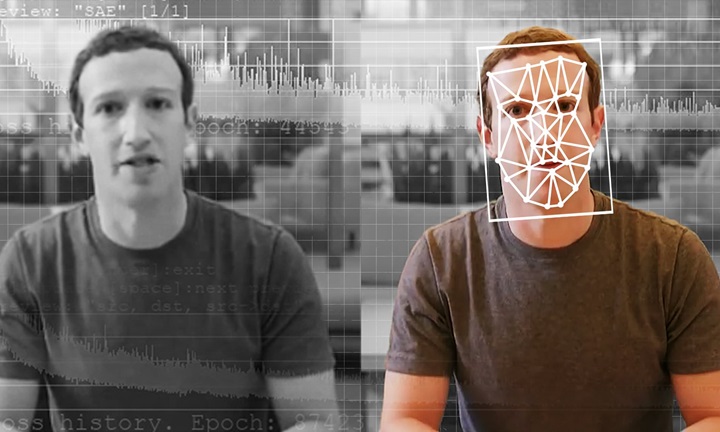

Bằng cách chứng minh việc một người có thể tạo dễ dàng tạo ra một bức ảnh giả mạo với chi phí khá rẻ, dự án của FireEye càng tăng thêm sức nặng cho những lo ngại về việc những thông tin sai lệch trên mạng có thể càng tệ hại hơn với sự giúp sức từ công nghệ AI, tạo ra hình ảnh hoặc lời nói giả mạo với chất lượng tương đối tốt. Những kỹ thuật đó và sản phẩm của nó thường được gọi là deepfake, một thuật ngữ được lấy từ tên của một tài khoản Reddit đã đăng tải các video khiêu dâm được tinh chỉnh sử dụng khuôn mặt của các nữ diễn viên Hollywood vào cuối năm 2017.

Hầu hết những sản phẩm deepfake trên mạng Internet đều có chất lượng thấp và được tạo ra cho mục đích khiêu dâm hoặc giải trí. Cho đến nay, công nghệ deepfake độc hại được sử dụng chủ yếu để quấy rối phụ nữ. Tuy nhiên, các dự án đến từ công ty hoặc sản phẩm truyền thông có thể tạo ra những hình ảnh khá mượt mà, bao gồm cả những video, bằng khoản ngân sách đầu tư lớn hơn. Các nhà nghiên cứu của FireEye muốn cho thấy cách mà ai đó có thể lợi dụng các nghiên cứu AI tinh vi chỉ với nguồn lực tối thiểu hoặc một ít chuyên môn về AI. Các thành viên của Quốc hội Mỹ đã bày tỏ lo ngại về việc deepfake có thể bị "bẻ cong" để can thiệp vào chính trị.

Các thử nghiệm deepfake của Tully đã tận dụng lợi thế tài nguyên đến từ các nhóm nghiên cứu AI học thuật và các công ty, họ công khai những tiến bộ mới nhất của mình và kèm theo các mã nguồn. Ông ấy đã sử dụng một kỹ thuật tinh chỉnh mà trong đó mô hình học máy được xây dựng với chi phí lớn, dựa trên một tập dữ liệu dồi dào các mẫu, được điều chỉnh cho phù hợp với một nhiệm vụ cụ thể với số lượng mẫu nhỏ hơn nhiều.

Những khuôn mặt này không hề có thật mà là sản phẩm của công nghệ AI. Ảnh: ThisPersonDoesNotExist.com

Để tạo ra Hanks giả, Tully đã tinh chỉnh một mô hình tạo khuôn mặt do Nvidia phát hành vào năm ngoái. Công ty chip đã tạo ra phần mềm bằng cách xử lý hàng triệu khuôn mặt mẫu trong vài ngày thông qua một cụm vi xử lý đồ họa mạnh mẽ. Tully đã điều chỉnh nó để phục vụ cho ý tưởng của mình trong vòng chưa đến một ngày trên một bộ xử lý đồ họa được thuê trên đám mây. Ngoài ra, ông ấy đã sao chép giọng nói của Hanks trong vài phút bằng chiếc laptop, 3 đoạn âm thanh 30 giây và bản tái tạo mã nguồn mở của sinh viên tốt nghiệp từ chương trình tổng hợp giọng nói của Google.

Khi sự cạnh tranh giữa các phòng thí nghiệm AI thúc đẩy những tiến bộ hơn nữa và những kết quả đó được chia sẻ, kết quả chúng mang lại sẽ ngày càng thuyết phục hơn, Tully nói. "Nếu điều này tiếp tục, sẽ có thể gây ra những hậu quả tiêu cực cho xã hội ở mức độ lớn hơn nhiều", ông nói. Trước đó, ông đã làm việc với một thực tập sinh để chứng minh rằng phần mềm tạo văn bản bằng AI có thể tạo ra nội dung tương tự như nội dung được sản xuất bởi Cơ quan Nghiên cứu Internet của Nga (IRA), cơ quan được cho là đã cố gắng thao túng cuộc bầu cử Tổng thống Mỹ vào năm 2016.

Tim Hwang, một thành viên nghiên cứu tại Trung tâm An ninh và Công nghệ mới nổi tại Georgetown, cho biết các thử nghiệm như của FireEye có thể làm cho những cuộc tranh luận về mối đe dọa đến từ deepfake tiếp tục nóng trở lại, thậm chí là chạm ngưỡng kích động. "Rất nhiều cuộc thảo luận về mối đe dọa này đã được thúc đẩy bởi những câu chuyện được thêu dệt đầy kịch tính", anh nói. Một ví dụ lặp lại là một cuộc bầu cử tổng thống trong tưởng tượng bị gian lận bởi một ứng cử viên deepfake hoàn hảo và đúng thời điểm.

Dự án của FireEye lấp đầy một số chi tiết thực tế bằng cách chỉ ra những gì có thể đạt được chỉ với nguồn lực hạn chế và thành quả đến từ mã nguồn mở của nghiên cứu AI. Hwang cho rằng việc kết hợp dạng thông tin như thế với những gì chúng ta đã biết về cách tổ chức thông tin sai lệch hoạt động sẽ là tốt hơn để đánh giá mối đe dọa từ deepfake hơn là cứ cố gắng soi ra các kịch bản xấu nhất có thể.

Mặc cho hình ảnh giả tạo Hanks của Tully, Hwang cho rằng có vẻ như một ứng dụng đột phá về deepfake vẫn chưa xuất hiện. IRA và những người khác đã đạt được khá nhiều thứ chỉ với số lao động rẻ và cơ sở hạ tầng công nghệ tương đối đơn giản, nhưng có lẽ sẽ không thu được nhiều kết quả thật sự từ các dự án AI nhỏ. Tạo nên một video deepfake phức tạp đòi hỏi nhiều thời gian và lượng chuyên môn đáng kể.

Hwang là tác giả của một báo cáo được công bố vào tháng trước kết luận rằng deepfake không đại diện cho một mối đe dọa "cấp tính" nào sắp xảy ra, nhưng dù sao thì xã hội vẫn nên chuẩn bị cho những phương án dự phòng. Báo cáo khuyến nghị các công ty và phòng thí nghiệm tạo nên "deepfake zoos" (tạm dịch: vườn thú deepfake) để thu thập các mẫu được tạo ra bởi các kỹ thuật mã nguồn mở khác nhau giống như những kỹ thuật đã được FireEye sử dụng để cùng hướng đến tạo ra một công cụ phát hiện deepfake. Một số công ty đã bắt đầu tham gia vào các dự án tương tự. Chẳng hạn như Nvidia đã công bố kết quả về biện pháp phát hiện gương mặt được tổng hợp bằng phần mềm của mình. Facebook dạo gần đây đã tạo ra một loạt video deepfake và trao thưởng 500.000 USD cho công cụ có thể phát hiện deepfake tốt nhất.

Các nhà nghiên cứu của FireEye cũng đang suy nghĩ về cách thức deepfake có thể phù hợp với các phương pháp hiện có trong kinh doanh thông tin sai lệch. Tully đã có buổi nói chuyện với Lee Foster, lãnh đạo của một nhóm thuộc công ty chuyên theo dõi các chiến dịch thao túng trực tuyến. Năm ngoái, công ty này đã vạch trần một chiến dịch thông tin sai lệch tràn lan ủng hộ Iran, sử dụng các nhân vật giả mạo trên Twitter và Facebook, thậm chí còn lừa các chuyên gia về chính trị Trung Đông tham gia vào các cuộc phỏng vấn sau đó được sử dụng để thúc đẩy thông điệp của hoạt động.

Foster cho biết kết quả của Tully và kinh nghiệm của chính ông ấy với những kẻ gieo rắc thông tin sai lệch đã khiến ông ấy nghĩ rằng họ có thể sớm chuyển sang phân tích sâu hơn deepfake. Ảnh hồ sơ đã được lấy ra từ các nguồn khác là manh mối mà các nhà điều tra thông tin sử dụng để vạch mặt những nhân vật giả mạo được dựng lên. Ông cho biết nội dung "Hanks giả mạo" không còn quá xa tiêu chuẩn chất lượng cần thiết để hỗ trợ cho những kẻ lừa đảo. "Những thứ này không cần phải quá hoàn hảo để có thể đủ thuyết phục trong một thế giới nơi mà chúng ta nhanh chóng tiếp nhận thông tin theo cách chúng ta muốn. Nếu bạn vuốt liên tục các bảng tin trên Twitter, bạn sẽ không thể xem xét kỹ lưỡng các ảnh profile", Foster nói.

(Theo VnReview, Wired)

Video deepfake Putin và Kim Jong Un gây sốt trên mạng

Video deepfake (hiệu ứng làm giả video ghép hình nhân vật) của Tổng thống Nga Putin và Chủ tịch Triều Tiên Kim Jong Un nói về nước Mỹ được chia sẻ nhiều trên mạng xã hội.